使用学习曲线和验证曲线 调试算法

这一节我们学习两个非常有用的诊断方法,可以用来提高算法的表现。他们就是学习曲线(learning curve)和验证曲线(validation curve)。学习曲线可以判断学习算法是否过拟合或者欠拟合。

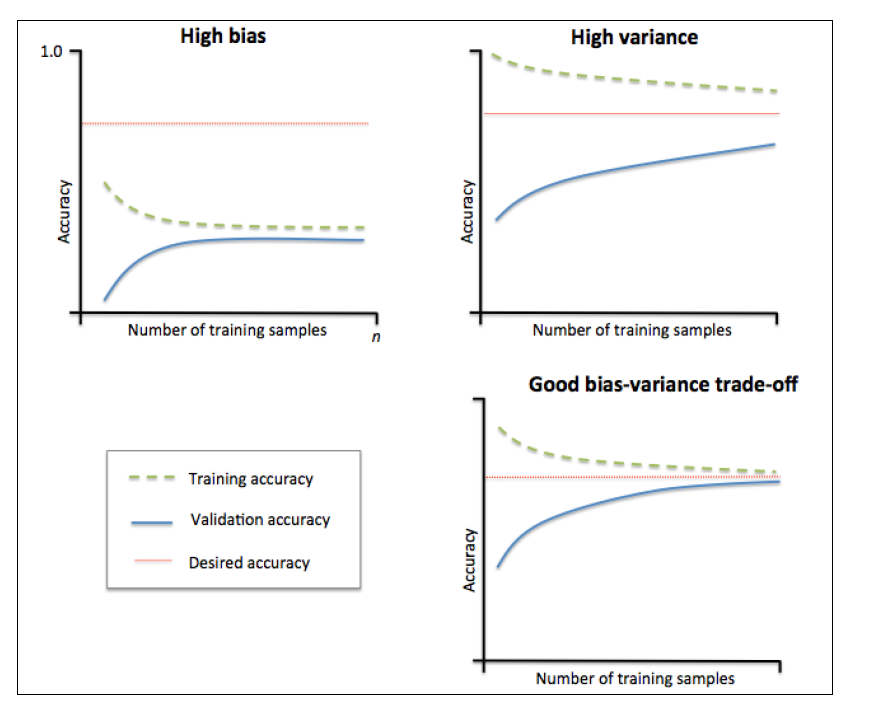

使用学习曲线判别偏差和方差问题

如果一个模型相对于训练集来说过于复杂,比如参数太多,则模型很可能过拟合。避免过拟合的手段包含增大训练集,但这是不容易做到的。通过画出不同训练集大小对应的训练集和验证集准确率,我们能够很轻松滴检测模型是否方差偏高或偏差过高,以及增大训练集是否有用。

上图的左上角子图中模型偏差很高。它的训练集和验证集准确率都很低,很可能是欠拟合。解决欠拟合的方法就是增加模型参数,比如,构建更多的特征,减小正则项。

上图右上角子图中模型方差很高,表现就是训练集和验证集准确率相差太多。解决过拟合的方法有增大训练集或者降低模型复杂度,比如增大正则项,或者通过特征选择减少特征数。

这俩问题可以通过验证曲线解决。

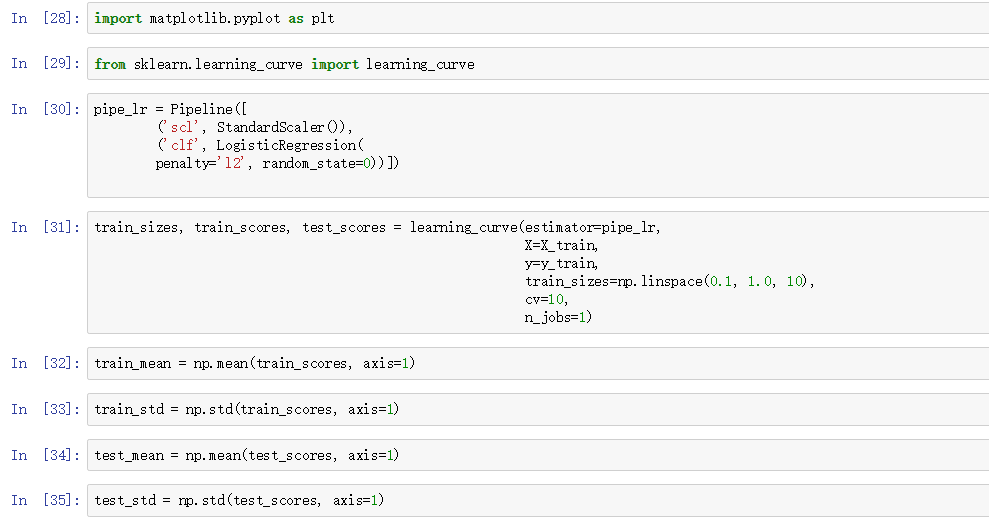

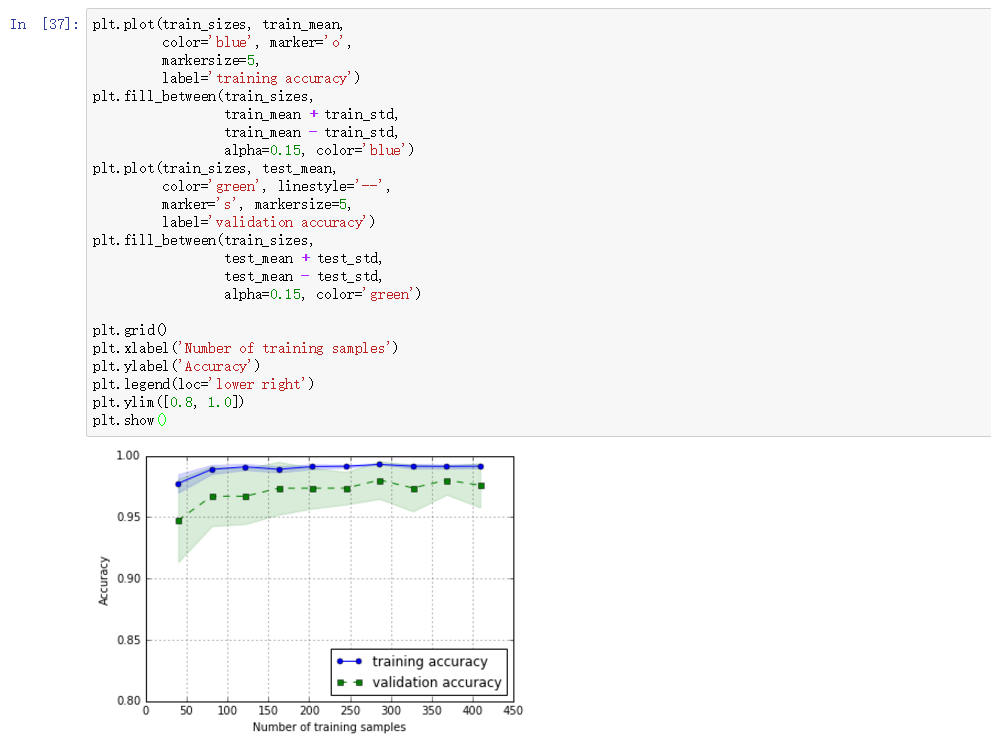

我们先看看学习曲线是怎么回事吧:

learning_curve中的train_sizes参数控制产生学习曲线的训练样本的绝对/相对数量,此处,我们设置的train_sizes=np.linspace(0.1, 1.0, 10),将训练集大小划分为10个相等的区间。learning_curve默认使用分层k折交叉验证计算交叉验证的准确率,我们通过cv设置k。

上图中可以看到,模型在测试集表现很好,不过训练集和测试集的准确率还是有一段小间隔,可能是模型有点过拟合。

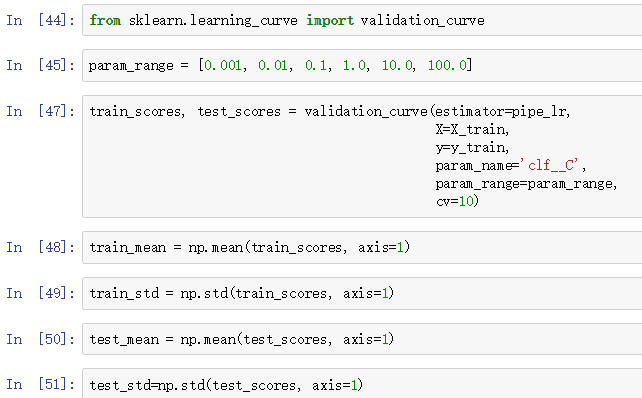

用验证曲线解决过拟合和欠拟合

验证曲线是非常有用的工具,他可以用来提高模型的性能,原因是他能处理过拟合和欠拟合问题。

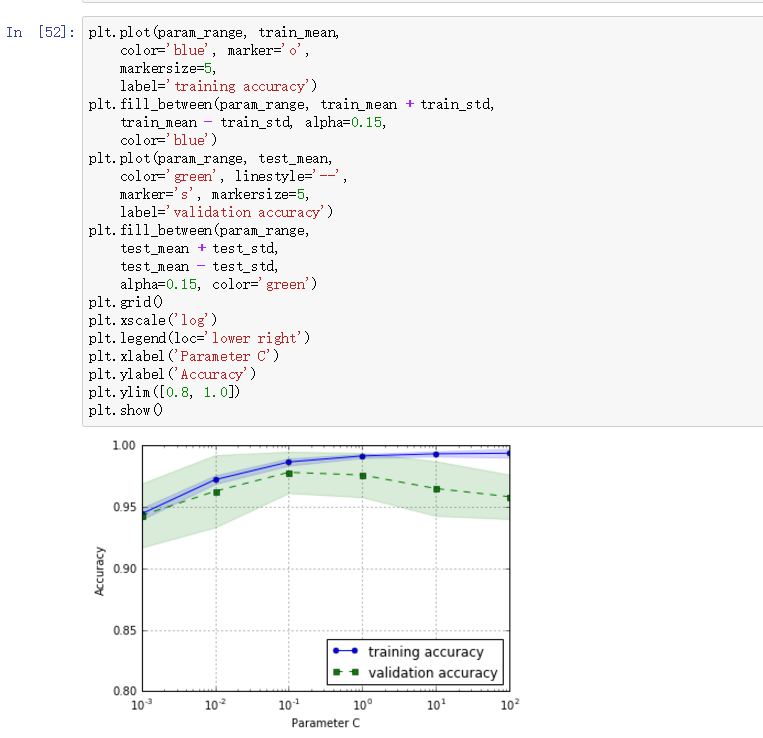

验证曲线和学习曲线很相近,不同的是这里画出的是不同参数下模型的准确率而不是不同训练集大小下的准确率:

我们得到了参数C的验证曲线。

和learning_curve方法很像,validation_curve方法使用采样k折交叉验证来评估模型的性能。在validation_curve内部,我们设定了用来评估的参数,这里是C,也就是LR的正则系数的倒数。

观察上图,最好的C值是0.1。